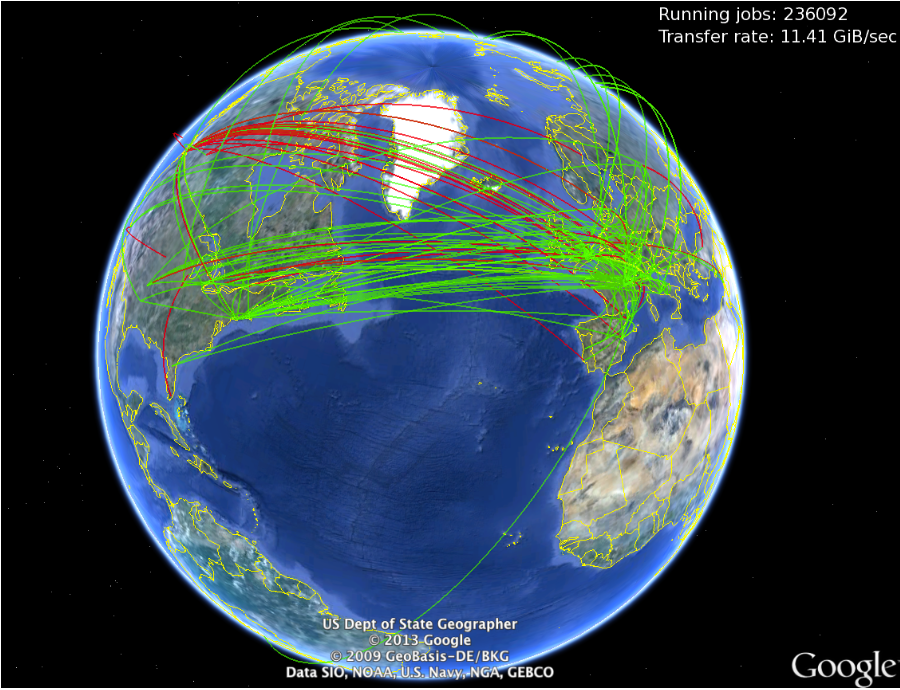

Le LAPP contribue à cet effort grâce à la plateforme MUST, dont le groupe ATLAS est un utilisateur majeur pour le temps de calcul et surtout pour le stockage. L’implication de l’équipe qui assure le suivi opérationnel quotidien en collaboration avec le groupe ATLAS du LAPP a fait de cet effort un succès, puisque MUST a été le premier site régional français labellisé comme « nucleus », c’est à dire suffisamment fiable pour héberger des données. MUST offre aussi une plateforme d’analyse locale des données. Ce résultat est le fruit d’une équipe mixte d’ingénieurs système et de physiciens connaissant les outils de placement de données et de surveillance du calcul spécifiques à la collaboration ATLAS.

En 2020, pratiquement 3,8 Po de stockage et 4000 processeurs sont utilisés au LAPP par la collaboration ATLAS. MUST héberge aussi une infrastructure de test pour déployer des versions beta de composants software de la Grille et participer à un programme de R&D. Les composants software et les outils de surveillance de la grille évoluent de plus en plus vers des composants standards de l’industrie informatique.

L’infrastructure déployée a été suffisamment performante pour faire les analyses de physique des Run-1 et Run-2. Le site est aussi prêt pour la campagne du Run-3 mais l’augmentation d’un ordre de grandeur de la quantité de données produite au LHC Haute-Luminosité (HL-LHC) ouvre de nouveaux défis à gérer, à budget et personnel constants. L’équipe ATLAS-MUST est impliquée dans le programme R&D DOMA de WLCG. Pour optimiser les performances de la Grille et minimiser le coût opérationnel, l’organisation des données en datalakes [2] est un des choix majeurs de ce programme.

Une autre demande au laboratoire mais aussi au niveau mondial est d’étendre ce type de service à d’autres communautés scientifiques. L’équipe, en liaison avec les équipes CTA et LSST du LAPP, contribue à la démonstration de la faisabilité de l’approche datalake à travers le projet multidisciplinaire ESCAPE initié par la Commission Européenne. Dans le cadre de ce programme, les sites de quatre laboratoires voisins (Annecy, Grenoble, Marseille, Clermont-Ferrand) se sont groupés en une fédération appelée ALPAMED [3], qui a été intégrée en 2019 aux datalakes ATLAS et ESCAPE.

Contacts : Stéphane Jézéquel, Frédérique Chollet, équipe MUST, Claire Adam-Bourdarios

Publications et articles :

- Overview of the ATLAS distributed computing system, CHEP 2018 conference proceedings

- Architecture and prototype of a WLCG data lake for HL-LHC, CHEP 2018 proceedings

- Implementation and performances of a DPM federated storage and integration with the ATLAS environment, CHEP 2019 conference talk by the ALPAMED team